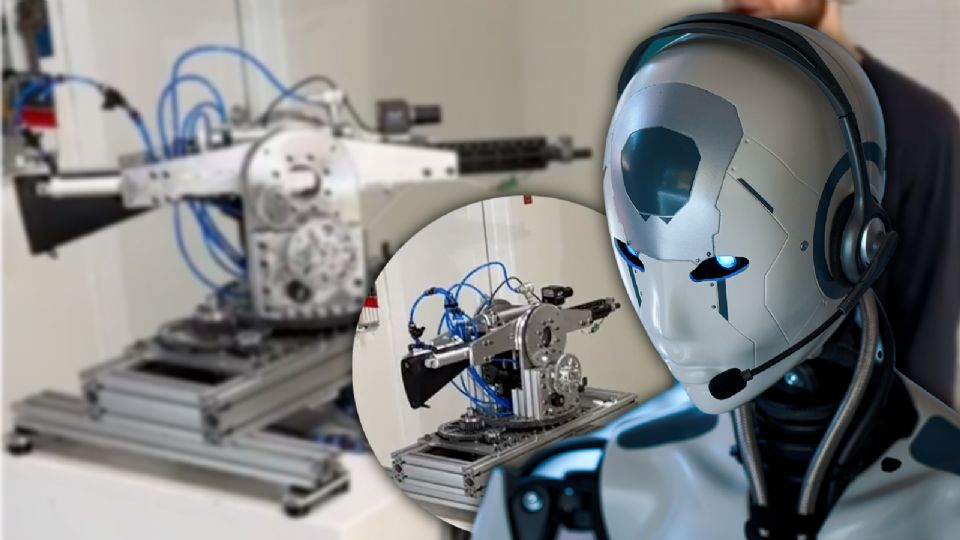

Un desarrollador e ingeniero estadounidense causó polémica, luego de que publicara un video en donde muestra su más reciente creación: se trata de un rifle robótico que obedece por medio de comandos de voz a través de ChatGPT, lo que puso en cuestión el uso que se le está dando en la actualidad a la inteligencia artificial, y sus posibles catastróficos finales.

El también creador de contenido identificado bajo el usuario 'STS 3D', mostró a través de un video en Reddit, cómo es que responde la IA de OpenAI, bajo ciertos comandos, haciéndola creer que está en un contexto de guerra.

"ChatGPT, estamos bajo ataque en el frente izquierdo y derecho. Responda como corresponde"; se escucha decir el desarrollador en el video.

Te podría interesar

Los preocupantes usos que se le está dando a la inteligencia artificial

Con un entrenamiento básico, ChatGPT era capaz de procesar órdenes como "gira a la izquierda" y traducirlas al lenguaje operativo del aparato. Esta demostración encendió el debate sobre los peligros de la automatización en sistemas letales.

De acuerdo con RT, el dispositivo utilizaba la API Realtime de OpenAI para interpretar comandos y transformarlos en instrucciones ejecutables por la máquina.

Te podría interesar

OpenAI reacciona a la creación del rifle robótico

Ya que el video se hizo bastante viral, llegando a los ojos de OpenAI, la empresa matriz de ChatGPT, reveló al portal ‘Futurism’ que ya habían identificado “de manera proactiva esta violación de nuestras políticas y notificamos al desarrollador que cesara esta actividad antes de recibir su consulta".

El portavoz de OpenAI aclaró que “las Políticas de Uso de OpenAI prohíben el uso de nuestros servicios para desarrollar o utilizar armas, o para automatizar ciertos sistemas que puedan afectar la seguridad personal”.

Este caso genera bastante preocupación por la falta de regulaciones entorno a la IA, y cuál es el límite humano entorno a la misma, ya que, como pudimos ver con el caso del Cybertruck de Tesla que explotó frente al hotel de Trump, cualquiera puede usar ChatGPT para realizar un atentado.